MLTensor에 대한 내용 자세히 길게 설명해줘 한글로

Asked on 2024-08-12

1 search

MLTensor는 Apple의 Core ML에서 제공하는 새로운 타입으로, 머신러닝 프레임워크에서 일반적으로 사용되는 수학 및 변환 연산을 지원하는 편리하고 효율적인 방법을 제공합니다. MLTensor는 Apple Silicon의 강력한 컴퓨팅 성능을 활용하여 높은 성능의 실행을 보장하며, Python의 수치 라이브러리와 유사한 구조를 가지고 있어 사용자가 더 쉽게 접근할 수 있습니다.

MLTensor는 다차원 배열로, 그 형태(shape)와 스칼라 타입에 의해 정의됩니다. 형태는 각 축의 길이를 지정하고, 스칼라 타입은 요소의 타입을 나타냅니다. MLTensor는 다양한 방법으로 생성할 수 있으며, ML 형태의 배열이나 스칼라의 중첩된 컬렉션을 사용하여 생성할 수 있습니다.

MLTensor는 다양한 수학 연산을 지원하며, 요소별 덧셈 및 곱셈과 같은 연산을 수행할 수 있습니다. 또한, 텐서를 인덱싱하여 각 차원을 슬라이스하거나 형태를 변환할 수 있습니다. 이러한 연산은 비동기적으로 처리되며, 텐서의 기본 데이터를 액세스하기 위해서는 명시적으로 ML 형태의 배열로 변환해야 합니다.

MLTensor는 특히 대형 언어 모델과의 통합을 단순화하는 데 유용합니다. 예를 들어, 자동회귀 언어 모델의 출력을 디코딩하는 과정을 간소화할 수 있습니다. 이러한 모델은 문맥에 따라 다음 단어나 토큰을 예측하여 문장을 생성합니다.

MLTensor에 대한 더 자세한 내용은 Deploy machine learning and AI models on-device with Core ML (03:29) 세션에서 확인할 수 있습니다.

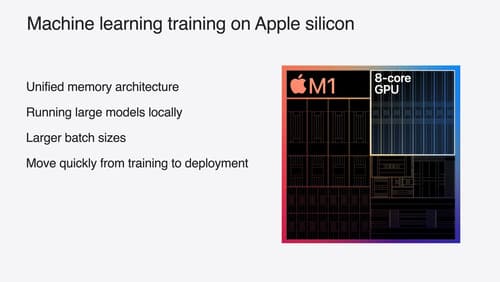

Train your machine learning and AI models on Apple GPUs

Learn how to train your models on Apple Silicon with Metal for PyTorch, JAX and TensorFlow. Take advantage of new attention operations and quantization support for improved transformer model performance on your devices.

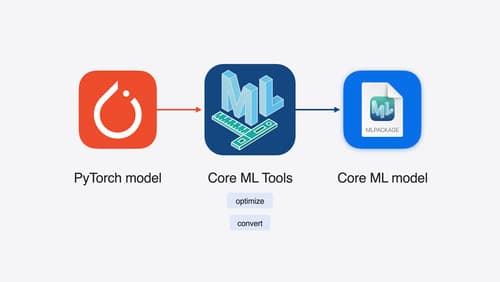

Bring your machine learning and AI models to Apple silicon

Learn how to optimize your machine learning and AI models to leverage the power of Apple silicon. Review model conversion workflows to prepare your models for on-device deployment. Understand model compression techniques that are compatible with Apple silicon, and at what stages in your model deployment workflow you can apply them. We’ll also explore the tradeoffs between storage size, latency, power usage and accuracy.

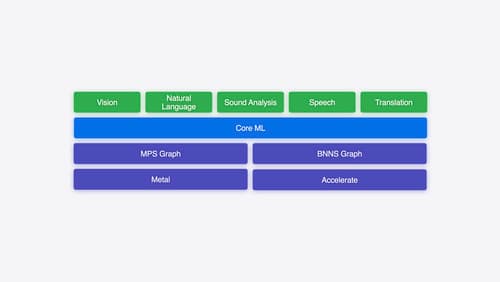

Explore machine learning on Apple platforms

Get started with an overview of machine learning frameworks on Apple platforms. Whether you’re implementing your first ML model, or an ML expert, we’ll offer guidance to help you select the right framework for your app’s needs.